Делюсь больше не конфигурацией сервера, а скорее историей тому как это все развивалось и к чему я пришел ![]()

Для тех кому лень читать, не осуждаю, вот текущая конфигурация:

Корпус: Fractal Design Define XL R2

Плата: Huananzhi X10X99-16D

CPU: Intel Xeon E5-2680 v4 x2

RAM: 128 Gb DDR4 2400Mhz

SSD: NVMe WD RED SN700 1TB

HDD: Seagate Ironwolf 4Tb ST4000VN008 x3, WD RED 4TB WD40EFRX для бекапов

БП: Cooler Master MWE Bronze V2 650W

Гипервизор: VMware ESXi 8.0u3

Букв будет много, за ошибки прошу прощения.

Этап 1.

Спойлер

Итак, началось все в 2018 году, а тот момент я уже несколько лет работал в тех. поддержке крупной компании, но уже ближе к системному администрированию и как-то так вышло, что в один момент я унал о существовании такой штуки как plex (не узнавал раньше наверное просто по тому, что не было такой потребности), такого корпуса как Fractal Design Node 304 в который влезает аж 6 HDD, так же у меня было нажито какое-то количество списанного железа в виде процессора i3 6100, пару планок ddr4 по 8 гб, старый БП и по сути оставалось приобрести только корпус и пару HDD. Изначальцо цель была собрать сетевое хранилище, в целом так и было, ни виртуалок, ни TrueNAS, ни docker.

Была докуплена самая дешевая на тот момент плата ASUS H110I-PLUS, пара новых WD RED по 4 Тб (до сих пор живы и используются), NVMe SSD под систему и так же у меня была пара десктопных HDD по 500 гб.

Сказано сделано - сервер был собран, установлена чистая Ubuntu Server, на него samba, plex и transmission.

Уже позже я само собой узнал о существовании и TrueNAS и много о чем еще, но текущая конфигурация выполняла мои задачи и переустнановка с перенастройкой системы в мои планы не вписывалась.

Работает, не трогай (с) из этого принципа исходят все мои решения которые могут показаться не оптимальными, где-то не верными и можно сделать лучше, но считаю это частью развития, просто возвращаться чтобы оптимизировать уже работающий сервис всегда тяжело, так что если знаете как сделать лучше, делайте сразу, потому что нет ничего более постоянного чем временное, не делайте как я ![]()

С програмной точки зрения все было примитивно, обуславливалось это тем, что по сути это было первое мое ± близкое знакомство с *nix системой (опыт с vps на данный момент не уитывается), да и до сих пор так сложилось что я Windows администратор, не бейте сильно.

За сетевку отвечал сначала стареньеий Mikrotik RB951G-2HnD, который позже был заменен на hAP ac2, так же родителям в другом городе был куплен hAP ac и между ними был поднят туннель, чтобы можно было помочь с ПК и тд, если потребуется без всяких тимвиверов и тд.

Таким образом еще началось мое более тесное изучение сетей и знакомство с Mikrotik в частности.

По мере погружения в администрирование я начал свое знакомство с Zabbix, на тот момент еще 4 версии, был развернут Apache, MySQL и собственной Zabbix прямо на NAS, какое-то время это так поработало, был сделан логичный вывод что мониторить надо снаружи и Zabbix как и сервер для туннеля переместился на VPS, который уже несколько лет был развернут и там работал сервер TeamSpeak3 (к слову жив до сих пор)

± в таком состоянии все это жило и работало где-то до конца 21 года, в программной части кардинально ничего не менялось, что-то добавлялось/удалялось в целом не существенно.

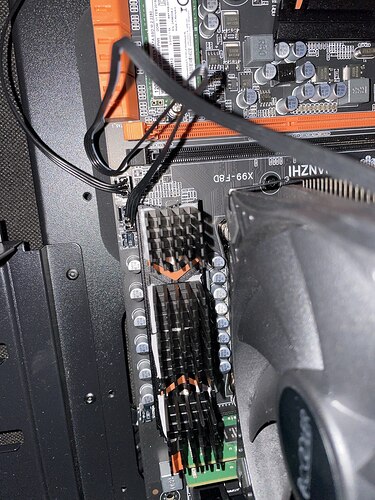

Вот примерно так это все выглядело:

Данный NAS пережил со мной два переезда (жилье съемное, так что по месту и коммуникациям всегда есть какие-то ограничения)

Этап 2.

Спойлер

В какой-то момент я понял что NAS по ресурсам становится тесноватым, этим моментом наверное было открытие для себя libvirt и в целом тесное знакомство с виртуализацией, внутри был развернут Windows Server 2016, с целью взять под контроль обновления и поднять сервер WSUS, все было поднято и прекрасно работало еще примерно пол года.

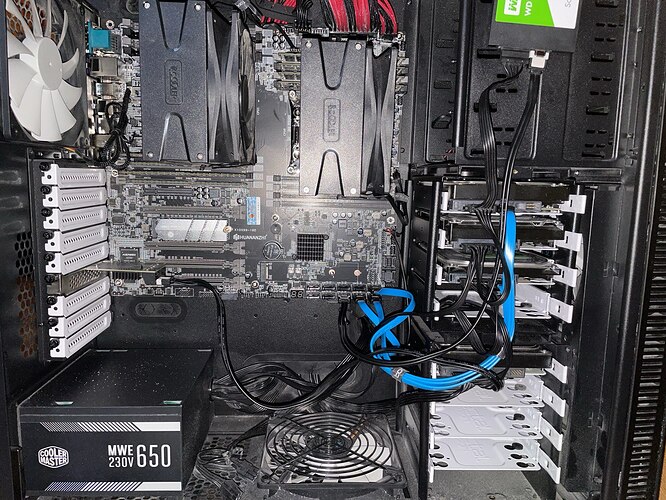

Изучая возможности апгрейда я открываю для себя китайские платы и дешевые Xeon, их потенциальную ненадежность я само собой осознавал (что в моем случае в целом не подтвердилось до сих пор), идея про какой-то апгрейд текущего NAS была отвергнута и куплена плата Huananzhi F8-D + 2 шт Intel Xeon E5-2666 v3 и 64 Гб DDR4 памяти (позже добавил еще 64), корпус подрос до Fractal Design Define XL R2, выбирался по принципу вмещения платы EATX и 8 HDD, так как текущий БП не имел отдельно 2 по 4-pin питания под процессор он был заменен на не дорогой Cooler Master MWE Bronze V2 650W.

Какое-то время перед окончательным перемещением систем с этим я игрался и тестировал разные ОС на открытом стенде, стабильность и тд.

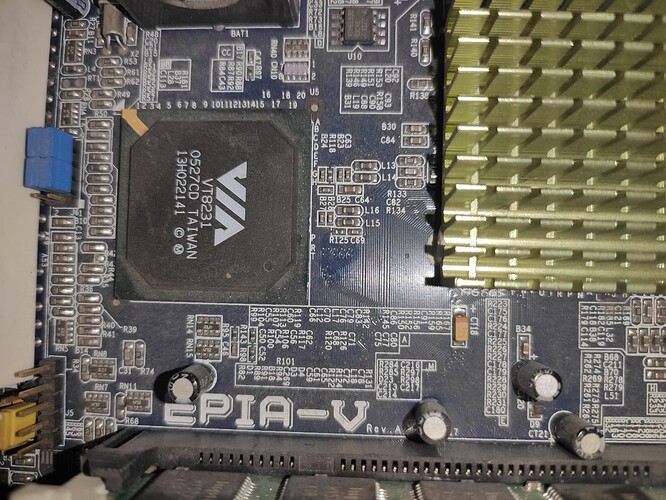

Беспокоила меня температура VRM, потому что 135 ватт TDP процессора для данной платы были болью, ничего лучше чем приклеить на теплопроводящий клей еще железных радиаторов я не придумал, но это сработало, температура с обратной стороны платы упала с 75 до 45 градусов:

Началось перемещение систем с NAS, из которого были вынуты диски, а сам он со всем остальным железом отправился на Авито, может быть благодаря нему кто-то тоже занялся самохостингом ![]()

Нашел фото с процесса сборки:

С программной стороны перемещение выполнялось не совсем обычное, а уже на гипервизор и нет это был не Proxmox, так как момент пересборки я работал уже системным администратором в другой еще более крупной компании, использовал соответственно с чем работал - VMware ESXi, версию 6.7 так как в нее можно было без проблем интегрировать драйверы для сетевых карт Realtek чипы которых китайцы ставят везде где только могут.

Та система которая была установлена на голое железо NAS была перенесена в виртуальную среду, Windows Server с WSUS который работал под libvirt тоже конвертирован и запущен уже как отдельная ВМ.

В дальнейшем с точки зрения железа каких-то сильных изменений не было, был докуплен еще один HDD на 4 Тб, уже не WD, а Seagate Ironwolf, простенький sata контроллер для пробрасывания его напрямую в ВМ, NVMe WD Red 1TB под сами виртуалки, еще 1 m2 SSD использовался тоже для виртуалок, просто чтобы как говорится не хранить яйца в одной корзине.

К слову о надежности китайских плат, за 3 года у данного сервера было всего три перезагрузки 2 из них плановые для чистки, одна по питанию, потому что я молодец и ИБП нет, просто потому что как-то избаловало меня хорошее электричество и за все это время на этой квартире был только один перебой электроэнергии, к слову кушало это все из розетки 190-210 ватт в простое.

Разумно ли такое потребление? Конечно нет. Стоило ли оно того? Однозначно да, для меня как администратора этот сервер выполнял и до сих пор выполняет отличную платформу для обучения/изучения/тестирования практически всего чего можно и придет в голову, да и не только для меня, в целом давал доступ и коллегам и друзьям ![]()

Так же сервер был выселен из основной комнаты на кухню под стол, шум конечно не сильный, но по сравнению с прошлым уже слышим особенно ночью, а так же даже будучи на сьемной квартире прокинуты в плинтусе два кабеля, так как маршрутизатор находится рядом с основным ПК.

По программной реализации спустя год регулярный набор ВМ пришел к такому виду:

Ubuntu:

Сервер приложений - plex и apache, так же коллектор логов Adiscon LogAnalyzer

Серер БД - MySQL, Postgresql

Файловый сервер - да, до сих пор просто samba и transmission ![]()

Сервер для сетевых сервисов: на него проброшены некоторые сетевые порты, Apache Guacamole, бэкдор для резервного входа в домашнюю сеть (активируется если основные точки входа недоступны), и некоторые другие сетевые сервисы

Windows Server:

Сервер контроллера домена: внутренний DNS, WSUS, AD CS (letsencrypt использую только для публичных сервисов), СРК Veeam Backup (избыточно, но исторически так сложилось и я с ней работал, мне удобно и да, я знаю что не рекомендуется ставить СРК на контроллер домена)

Сервер приложений - WebApp, сервер 1С, PowerBI, небольшой сервер Minecraft под виндой да, а что вы мне сделаете)

Сервер БД MS SQL - полностью изолирован от всех сегментов сети и интернета в том числе, используется для тестирования, как сервер для PowerBI и 1С, доступ открывается только для порта БД

Терминальный сервер - для для друзей и коллег, на него можно зайти из интернета используя Guacamole с LDAP авторизацией, умеет во вложенную виртуализацию в виде Hyper-V, изолирован от основной домашней сети в которой находятся серверы на Ubuntu, имеет доступ в интернет через прокси.

Прочее:

pfSense - для сегментации сети ВМ используя vSwitch

TrueNAS - разворачивался с целью потестировать, в итоге сейчас выполняет задачу прокинуть физический диск с помощью iSCSI в ВМ с Veeam Backup, чтобы бекапы хранились без виртуальных дисков.

Так же после перемещение на виртуализацию домашних сервисов, VPS тоже переместился на другого хостера, с европейского на российский, на нем развернулся PiHole + Unbound для форвардинга внутренних доменных имен, доступный только через туннель, Zabbix развернутый в 2018 успешно переехал и обновлен до 6.0, туннель стал использовать немного другой протокол и теперь основная его задача обьеденить сети дома у родителей и мою, так же все сервисы развернутые на моей виртуализации и VPS доступны бесшовно из сети родителей, включая домен, Mikrotik hAP ac2 и обычный hAP ac у родителей были обновлены до RB5009 у меня и hAP ax2 у родителей.

Этап 3.

Спойлер

В целом с момента запуска виртуализации в 2022 году меня все устраивало, все работало стабильно, не зависало и было хорошо.

Но меня всегда беспокоили несколько моментов:

- У данной платы не было функции включения после потери питания, а WOL отрабатывал как-то слишком уж не стабильно

- Чипы сетевых карт Realtek блокировали возможность обновить ESXi до 7 или 8 версии, так как там отсутствует возможность нормально интегрировать драйверы

- Невозможность нормальной диагностики железа в случае поломки, без перемещения к монитору и вот это вот все

- Отсутствие каких-либо датчиков и возможности мониторинга температур, оборотов куллеров и тд

- Скорость сети ограничена 2х1гб/с

Все эти пункты можно обьеденить в один - общая сомнительная надежность системы даже не смотря на аптаймы больше года.

За это время я рассматривал всякие разные платы на 2011-3, смотрел и в сторону двухпроцессорных Lenovo и в сторону Supermicro X10dri, но в итоге на апгрейд я решился совершенно случайно, на маркетплейсе в рекомендациях заметил очередное поделие от китайцев Huananzhi X10X99-16D, ценник на нее был в два раза выше того, за который я покупал текущий хуанан, от части думаю на это повлияла экономическая ситуация но и в целом она явно должна быть дороже по ряду причин: - Сеть 2х2,5гб/с на чипах от Intel

- Присутствует встроенная графика, а значит минус видеокарта и минус энергопотребление

- Полноценный BMC, внезапно, от китайцев не ожидал, но оно работает

Эти три фактора стали для меня решающими, в мае этого года плата была куплена в комплекте с двумя Intel Xeon E5-2680 v4, уже зная приколы китайцев с охлаждением VRM заранее у умельцев на Авито были заказаны усиленные радиаторы, чтобы не колхозить как прошлый раз.

Каких-то внезапностей в процессе замены платы не возникло, ESXi был обновлен до 8 версии и переехал с флешки на SSD, потому что прошлая 6.7 версия была установлена на флешке которая уже периодически отваливалась, но это не влияло на работу потому что система по факту живет в оперативной памяти после загрузки, но могла не подняться после выключения.

Все ВМ после запуска включились как будто ничего не изменилось, проблем замечено не было.

Как итог после апгрейда я получил полноценный BMC, полный удаленный контроль над железом и температурами, сеть 2х2,5гб/с, дополнительный слот NVMe, 2 порта U2 для серверных SSD, а так же снижение общего энергопотребления из за снижения TDP процессоров и отключения видеокарты за ненадобностью, теперь с текущей постоянной нагрузкой потребление 105-130 ватт против 210 в среднем у прошлой конфигурации и этот результат меня вполне устраивает ![]()

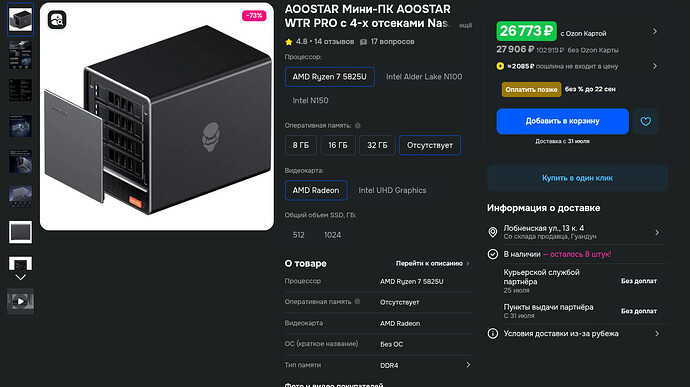

Из ближайших апгрейдов планируется наконец-то покупка ИБП и возможно покупка U2 диска для использования под БД и еще одного NVMe под виртуалки, чтобы все не было на одном диске.

Оптимально? Да нет конечно) Есть что оптимизировать, урезать, использовать ресурсы более разумно, но это уже совсем другая история.

Почему не Proxmox? Потому что, просто потому что, нет причин. На текущий момент уже исторически так сложилось.

Где докер? А вот нету) Благодаря этому ресурсу теперь буду внеднять потихоньку, потому что заметил несколько интересных для себя вещей для домашней сети, но докеризировать все подряд я все таки не хочу.

Вот такой вот путь ![]()

P.S. Если кому-то интересны дополнительные аспекты, готов ответить на любые вопросы.

По поводу вопросов лицензирования всего что перечислено, оставим это на моей совести. Будем считать что везде используются ознакомительные версии.